Soy un firme creyente en la promesa de la inteligencia artificial (IA): una herramienta que, si se usa de forma inteligente, puede dar a los proveedores de atención médica superpoderes al poner la información correcta a su alcance en los momentos realmente importantes para ellos y a sus pacientes. Sin embargo, también creo que para cumplir esa promesa, primero debemos enfocarnos en las personas y no en la tecnología.

En conversaciones con líderes en materia de atención médica de todo el mundo, un desafío generalmente común es la dificultad de encontrar suficientes médicos especializados para satisfacer la creciente necesidad de atención médica. En ese punto, me gustaría preguntar: ¿qué pasaría si pudiéramos hacer que sus médicos existentes sean dos veces más efectivos y eficientes, permitiéndoles tomar mejores decisiones mientras pasan más tiempo con los pacientes?

Esa es esencialmente la promesa de la IA, ya sea a través de la automatización de tareas mundanas que distraen el enfoque del médico en los pacientes, o al proporcionar apoyo en la toma de decisiones clínicas en los momentos que finalmente tienen el poder de conducir a mejores resultados de salud.

Y, sin embargo, a pesar de todos sus avances tecnológicos, sorprendentemente pocas aplicaciones de IA se han abierto camino con éxito desde el laboratorio de investigación hasta la práctica clínica. ¿Qué está frenando a la IA en la atención médica?

Superando las barreras para la adopción de la IA

Problemas relacionados con la gestión de datos y la interoperabilidad a menudo se presentan como los principales cuellos de botella para una adopción más amplia de la IA, y con buena razón. Pero en la agitada y estresante realidad cotidiana de los profesionales médicos, también hay otros factores en juego. Factores humanos.

Los profesionales médicos a menudo trabajan en horarios ajustados, confiando en rutinas construidas durante años de experiencia. Si la IA no encaja perfectamente en sus flujos de trabajo, o peor aún, si crea una complejidad adicional, los médicos tendrán dificultades para adoptarla. Y en un entorno de alto riesgo como lo es la atención médica, donde los profesionales médicos tienen que tomar decisiones en fracciones de segundo con consecuencias potencialmente de largo alcance, puede ser difícil ganar confianza en la nueva tecnología. ¿Confiaría en la recomendación de un algoritmo cuando la vida de un paciente está en sus manos? Tanto el mal ajuste del flujo de trabajo como la falta de confianza han demostrado obstaculizar la adopción de la IA [1,2].

Las innovaciones de atención médica anteriores enfrentaron algunos de los mismos desafíos de adopción. Basta con pensar en la Historia Clínica Electrónica (EMR). Originalmente fue promocionada como el futuro de la atención médica, ahora se reconoce ampliamente que las EMR no fueron diseñadas suficientemente teniendo en cuenta las necesidades y experiencias de los profesionales médicos, y los médicos lamentaban tener que estar «atrapados detrás de sus pantallas» [3, 4]. Esta vez, con la IA alimentando la próxima ola de innovación digital, debemos aprender de los errores del pasado y adoptar un enfoque radicalmente diferente. Uno que ponga a las personas al frente y al centro del escenario. No como una ocurrencia tardía, sino desde el principio.

Médicos e IA: el nuevo equipo médico mejorado

Lo que la atención médica necesita es IA centrada en el ser humano: Inteligencia artificial que no está impulsada simplemente por lo que es técnicamente factible, sino ante todo por lo que es humanamente deseable. Esto significa que necesitamos combinar la ciencia de datos y la experiencia técnica con una sólida comprensión del contexto clínico en el que operan los profesionales médicos, así como las demandas cognitivas y emocionales de su realidad diaria.

Pensar en los profesionales médicos y la IA como un sistema colaborativo es esencial en esta instancia. Si bien la IA podría superar cada vez más a los médicos en tareas específicas, la IA y el conocimiento clínico profundo deben ir de la mano porque ambos tienen sus fortalezas y limitaciones únicas. Lograr correctamente que esta relación complementaria es lo que en última instancia determinará la adopción y el impacto de la IA en la atención médica.

Lo que la atención médica necesita es una IA centrada en el ser humano: inteligencia artificial que no esté impulsada simplemente por lo que es técnicamente factible, sino principalmente y como prioridad todo por lo que sea humanamente deseable.

Ya vemos los primeros contornos de la colaboración entre el ser humano y la IA en la radiología; una disciplina que siempre ha estado a la vanguardia de la transformación digital en la atención médica, y que ahora es un semillero fértil para la innovación en IA. Dado que los radiólogos y el personal de imagenología son escasos en muchas partes del mundo, y enfrentan cargas de trabajo cada vez mayores, ciertamente podrían beneficiarse de tener un asistente digital inteligente.

Pero, ¿cómo nos aseguramos de que la IA complemente a estos expertos humanos de tal manera que juntos logren más de lo que cualquiera de los dos podría lograr por sí mismos? Claramente, la respuesta no se va a presentar en bandeja de plata si nos centramos en la tecnología de manera aislada.

Durante mucho tiempo he creído que para ofrecer una innovación significativa a las personas, es necesario innovar junto a ellas en lugar de para ellas. Como argumenté en la Conferencia Fortune Brainstorm Design hace algún tiempo, la creación de algoritmos en los confines de un laboratorio de investigación en sí misma no nos traerá una IA centrada en el ser humano. En cambio, primero debemos salir y sumergirnos en la realidad cotidiana de las personas cuyas vidas estamos intentando mejorar.

Eso es exactamente lo que estamos haciendo con nuestros socios clínicos y académicos, como el Hospital Catharina y la Universidad Tecnológica de Eindhoven (como parte de nuestra colaboración conjunta e/MTIC [i]) y el Centro Médico de la Universidad de Leiden en los Países Bajos, realizando análisis de flujo de trabajo de 360 grados in situ y sesiones de co-creación con expertos médicos para ver más allá de la tecnología en sí y comprender el contexto completo de uso.

A través de este trabajo, estamos comenzando a descubrir los impulsores de la experiencia que fomentan una fuerte colaboración entre el profesional médico y la IA en radiología. Y lo que ha quedado muy claro es que diseñar para una IA centrada en el ser humano implica mucho más que crear una interfaz de usuario superior.

Lo que es técnicamente posible puede no ser lo que realmente se necesita

Antes que nada, debemos preguntarnos: ¿qué tipo de IA sería útil en primer lugar? Esto parece una pregunta obvia, pero las aplicaciones de IA a menudo no se traducen a la práctica clínica precisamente porque la necesidad subyacente o el punto crítico ha sido mal definido.

Por ejemplo, si un algoritmo de análisis de imágenes es simplemente capaz de identificar anomalías que un radiólogo puede detectar de un vistazo, su valor agregado puede ser limitado a pesar de su sólido rendimiento técnico. O digamos que tiene un algoritmo que ayuda a medir el tamaño de un tumor: puede ser un poco más preciso que un observador humano, pero si la diferencia es tan pequeña que no afecta prácticamente las decisiones respecto al tratamiento, no hay un beneficio real para el paciente.

En cambio, si adoptamos una visión de pensamiento sistémico, a partir de las necesidades del radiólogo y otras partes interesadas en el flujo de trabajo de radiología, incluido el paciente y el técnico de radiología que realiza el examen, podemos identificar oportunidades donde la IA tendrá el mayor valor agregado. Dichas oportunidades podrían estar en cualquier etapa del flujo de trabajo.

Por ejemplo, al principio del flujo de trabajo, la IA puede ayudar a optimizar el agendado de los pacientes para que estos sea vistos lo más rápido posible. O bien, puede ayudar a los técnicos en radiología en la selección y preparación de los exámenes de imagenología apropiados para un paciente específico y así evitar nuevos escaneos innecesarios. Una vez que se han adquirido las imágenes, la IA puede apoyar a los radiólogos de varias formas, por ejemplo, señalándoles hallazgos incidentales que son fáciles de pasar por alto, o ahorrándoles tiempo a través de la integración automática de los hallazgos en el informe.

Hay muchos más casos de uso en los que uno podría pensar, algunos de los cuales estamos explorando activamente con nuestros socios clínicos. Identificar los puntos débiles y mapear las oportunidades a lo largo de todo el flujo de trabajo es una excelente forma de iniciar un programa de innovación de IA, ya que crea un enfoque compartido en el valor que la IA puede aportar en cada paso.

La IA debe ser una parte integral del flujo de trabajo

Si bien definir el valor agregado previsto de la IA es un punto de partida vital, es la forma en que la IA encaja en el flujo de trabajo, y en última instancia puede ayudar a agilizarlo, lo que logrará o impedirá la adopción en la práctica clínica.

Si hay algo que hemos aprendido a través de nuestras colaboraciones con socios del sector de radiología, es que lo que puede parecer una aplicación útil en teoría llevada a la práctica puede resultar una carga para el radiólogo si se siente como «agregar otro paso» a su flujo de trabajo. Los radiólogos trabajan en un entorno complejo y con presión debido al tiempo, ejecutando diferentes aplicaciones de software en paralelo y en múltiples pantallas. Es por eso que es realmente importante que integremos aplicaciones de IA en sus soluciones, de imagenología e informática existentes, haciendo que la información esté fácilmente disponible al alcance de la mano, en lugar de agregar a un mosaico de soluciones puntuales.

Pero debemos pensar aún más holísticamente sobre la integración del flujo de trabajo, mirando el sistema de diagnóstico en general. Por ejemplo, la IA podría hacer un análisis preliminar de la tomografía computarizada de un paciente para señalar los casos preocupantes que requieren un seguimiento inmediato con una tomografía computarizada por PET. En sí misma, esta aplicación sería muy útil. Sin embargo, solo funcionaría si se puede disponer de espacio entre las citas para realizar PET-CT ese mismo día, lo que presenta un nuevo desafío de flujo de trabajo (¡uno que la IA también podría ser capaz superar!). Como muestra este ejemplo, debe observar el sistema de trabajo de todo el hospital, no solo los elementos individuales del flujo de trabajo.

La IA debe infundir la confianza adecuada que coincida con sus capacidades

Otro desafío de diseño planteado por la IA, al que aludí anteriormente, es lograr que los médicos confíen en sus resultados y recomendaciones. Con el auge del aprendizaje profundo, los sistemas de IA se han vuelto mucho más precisos y poderosos, pero también se han vuelto cada vez más difíciles de interpretar, lo que exige un salto de fe del usuario. La confianza es fundamental para la adopción, pero es difícil de ganar. La confianza también se pierde fácilmente cuando el sistema de IA da algunas recomendaciones erróneas, incluso si funciona de manera altamente precisa en general.

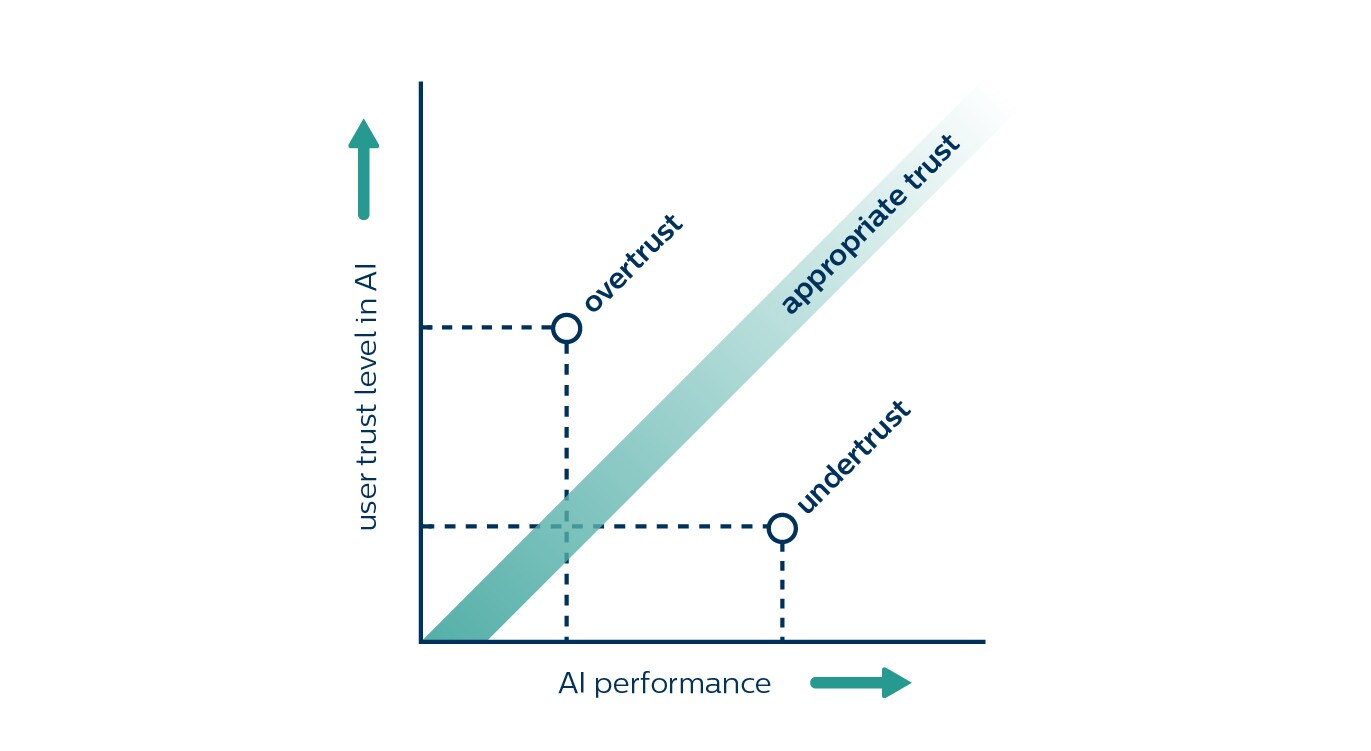

Y lo complicado es que cuando se trata de confianza, también puede haber demasiado de algo bueno. No querrá que un radiólogo confíe ciegamente por los hallazgos de un algoritmo cuando el algoritmo a veces pasa por alto una enfermedad. Lo que desea es una confianza adecuada que coincida con las capacidades de la IA. Esto significa navegar por una delgada línea entre la falta de confianza y la confianza excesiva.

La falta de confianza ocurre cuando la confianza no se compagina con las capacidades reales de la IA. Varios estudios han demostrado cómo los radiólogos pasaron por alto los cánceres pequeños identificados por la IA [5,6]. En el otro extremo, la confianza excesiva conduce a una dependencia desproporcionada en la IA, lo que hace que los radiólogos omitan cánceres que la IA no pudo identificar [7].

¿Cómo ayuda a los radiólogos a encontrar el equilibrio adecuado entre la confianza y la vigilancia?

En primer lugar, es esencial que entiendan lo que un sistema de IA puede y no puede hacer, con qué datos fue entrenado y para qué se ha optimizado. Por ejemplo, un algoritmo se puede optimizar para detectar tumores pequeños en los pulmones, pero por lo tanto podría pasar por alto los más grandes. Esto no es en absoluto intuitivo para el radiólogo y requiere una comunicación activa para evitar la desconfianza. Los radiólogos también querrán saber qué tan bien la IA hace lo que se supone que debe hacer, y pedirán transparencia en su validación y rendimiento.

Además, debemos considerar cómo podemos hacer que los hallazgos de la IA sean lo más comprensibles y necesarios que sea posible. Si bien la interpretabilidad puede no ser tan importante cuando hay poco en juego, en una situación de alto riesgo, la naturaleza similar a la caja negra de un sistema de IA puede ser un impedimento para que se genere confianza. Junto con nuestros colaboradores clínicos y socios académicos, como la Universidad Tecnológica de Eindhoven, estamos investigando varias formas de abordar este problema, ya sea explicando la filosofía de diseño de la IA en general o proporcionando la justificación de las recomendaciones individuales.

Poniendo a las personas en primer lugar

Por supuesto, las percepciones de los profesionales médicos sobre la IA continuarán evolucionando a medida que maduren sus capacidades. Al igual que un residente junior que se une por primera vez a un equipo, la IA necesita demostrar su valor agregado y ganar confianza con el pasar del tiempo.

Con la IA como un colaborador de confianza que está perfectamente integrado en el flujo de trabajo, los radiólogos se liberarán de las tareas mundanas y podrán dedicar más tiempo a casos complejos, lo que aumentará su impacto en la toma de decisiones clínicas. Los profesionales de la salud en otras áreas de la medicina también se beneficiarán cada vez más de la asistencia de IA, ya sea en patología digital, cuidados agudos, terapia guiada por imágenes, o gestión de enfermedades crónicas. Creo firmemente que hará que su trabajo sea más valioso y gratificante, no menos.

Pero como he esperado demostrar, ese futuro no sucederá por sí solo. Solo sucederá por diseño.

Los diseñadores deben asumir un papel activo desde el principio del desarrollo de la IA, trabajando junto con científicos de datos, ingenieros y expertos clínicos para crear experiencias habilitadas para la IA que marquen una diferencia positiva tanto para los profesionales de la salud como para los pacientes.

Solo entonces veremos que la IA en la atención médica cumplirá con su promesa a plenitud; si ponemos a las personas y no a la tecnología en primer lugar.

Nota

[i] e/MTIC o Eindhoven MedTech Innovation Center es una colaboración de investigación entre la Universidad Tecnológica de Eindhoven, el Hospital Catharina, el Centro Médico Maxima, el Centro de Epilepsia y Sueño de Kempenhaeghe y Philips.

Referencias

[1] Christopher J. Kelly, Alan Karthikesalingam, Mustafa Suleyman, Greg Corrado, and Dominic King. 2019. Key challenges for delivering clinical impact with artificial intelligence. BMC Medicine 17, 1: 195. https://doi.org/10.1186/s12916-019-1426-2

[2] Lea Strohm, Charisma Hehakaya, Erik R. Ranschaert, Wouter P. C. Boon, and Ellen H. M. Moors. 2020. Implementation of artificial intelligence (AI) applications in radiology: hindering and facilitating factors. European Radiology. https://doi.org/10.1007/s00330-020-06946-y

[3] Atul Gawande. 2018. Why doctors hate their computers. New Yorker. https://www.newyorker.com/magazine/2018/11/12/why-doctors-hate-their-computers

[4] Robert M. Wachter. 2015. The digital doctor: hope, hype, and harm at the dawn of medicine’s computer age.

[5] D. W. De Boo, M. Prokop, M. Uffmann, B. van Ginneken, and C. M. Schaefer-Prokop. 2009. Computer-aided detection (CAD) of lung nodules and small tumours on chest radiographs. European Journal of Radiology 72, 2: 218–225. https://doi.org/10.1016/j.ejrad.2009.05.062

[6] Robert M. Nishikawa, Alexandra Edwards, Robert A. Schmidt, John Papaioannou, and Michael N. Linver. 2006. Can radiologists recognize that a computer has identified cancers that they have overlooked? In Medical Imaging 2006: Image Perception, Observer Performance, and Technology Assessment, 614601. https://doi.org/10.1117/12.656351

[7] W. Jorritsma, F. Cnossen, and P. M. A. van Ooijen. 2015. Improving the radiologist–CAD interaction: designing for appropriate trust. Clinical Radiology 70, 2: 115–122. https://doi.org/10.1016/j.crad.2014.09.017

[8] John D. Lee and Katrina A. See. 2004. Trust in automation: designing for appropriate reliance. Human Factors 46, 1: 50-80. https://doi.org/10.1518/hfes.46.1.50_30392

Comparta en sus redes sociales

Temas

Autor

Sean Carney

Former Chief Experience Design Officer at Royal Philips from 2011 to 2022